来源:https://developers.googleblog.com/en/introducing-coral-npu-a-full-stack-platform-for-edge-ai

日期:2025-10-15

生成式人工智能从根本上重塑了我们对技术的期望。我们已经见证了大规模云端模型在创造、推理和辅助方面的惊人能力。然而,下一次重大技术飞跃不仅仅是让云端模型更大;关键在于将它们的智能直接嵌入我们身边的个人环境中。为了使人工智能真正具备辅助性——主动帮助我们安排日常事务、实时翻译对话或理解我们的物理环境——它必须运行在我们佩戴和携带的设备上。这带来了一个核心挑战:如何将环境感知的人工智能嵌入电池受限的边缘设备,使其摆脱对云端的依赖,从而实现真正私密、全天候的辅助体验。

要从云端转向个人设备,我们必须解决三个关键问题:

性能差距:复杂的、最先进的机器学习(ML)模型需要更多计算资源,远远超出边缘设备的有限电力、散热和内存预算。

碎片化成本:为了适应多样化的专有处理器而编译和优化机器学习模型既困难又昂贵,阻碍了跨设备的性能一致性。

用户信任缺失:为了真正提供帮助,个人AI必须优先考虑个人数据和上下文的隐私与安全。

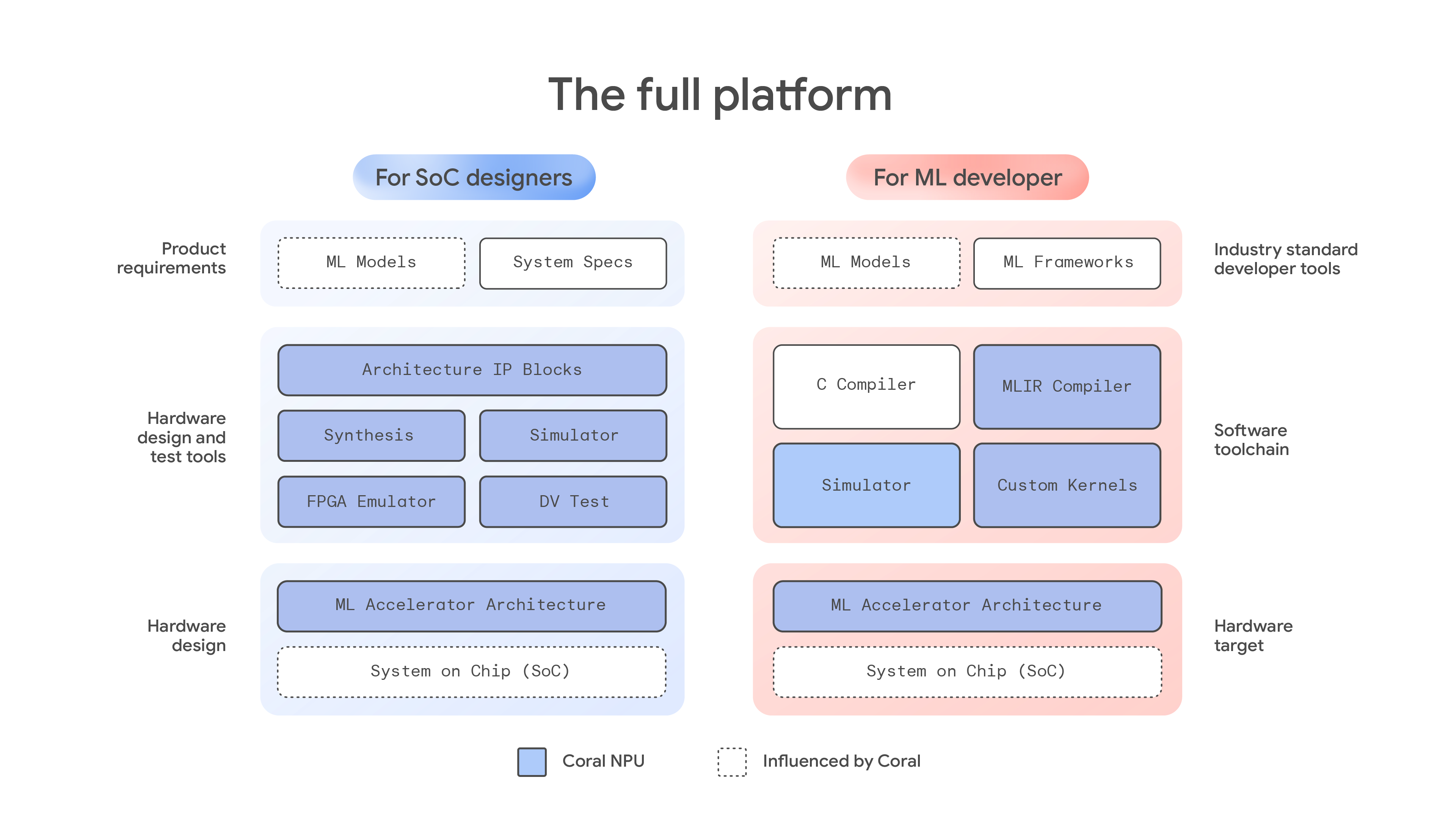

今天,我们推出了 Coral NPU,这是一个全栈平台,基于我们最初的 Coral 工作,为硬件设计师和机器学习开发者提供构建下一代私有、高效边缘 AI 设备所需的工具。Coral NPU 是与 Google Research 和 Google DeepMind 共同设计的 AI 优先硬件架构,旨在实现新一代超低功耗、全天候运行的边缘 AI。它提供统一的开发者体验,使部署如环境感应等应用变得更加容易。它专为在可穿戴设备上实现全天候 AI 而设计,同时将电池使用降到最低,并可配置以满足更高性能的使用场景。我们已经发布了文档和工具,方便开发者和设计师今天就开始构建。

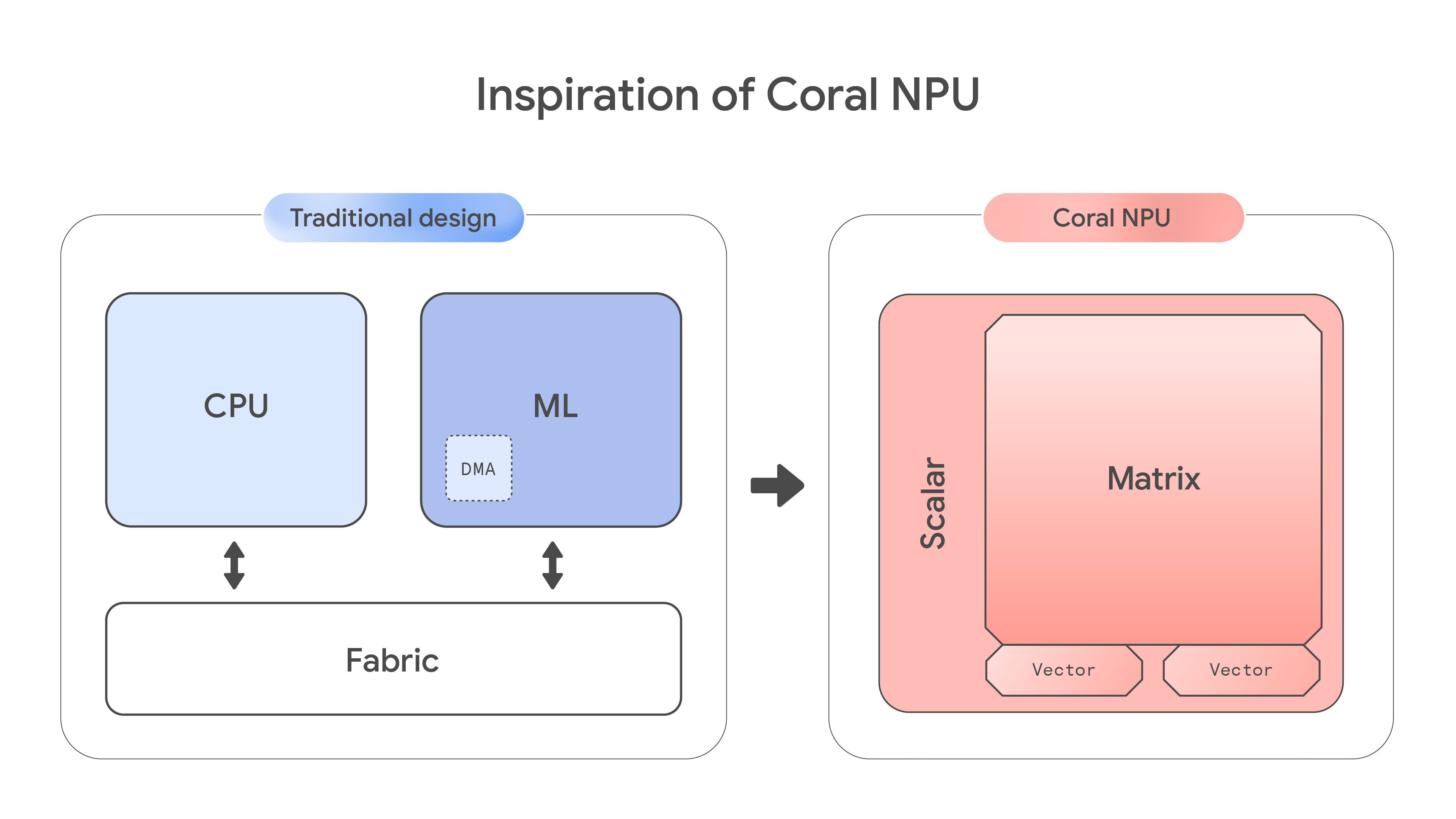

为低功耗边缘设备开发的开发者面临一个根本性的权衡,需要在通用CPU和专用加速器之间进行选择。通用CPU提供重要的灵活性和广泛的软件支持,但缺乏针对高要求的机器学习工作负载的特定领域架构,因此性能较低且功耗效率不高。相反,专用加速器提供高效的机器学习性能,但灵活性差,编程困难,不适合一般任务。

这一硬件问题由于高度碎片化的软件生态系统而被放大。由于 CPU 和 ML 模块的编程模型迥异,开发者常常被迫使用专有的编译器和复杂的命令缓冲区。这造成了陡峭的学习曲线,并使得不同计算单元的独特优势难以结合。因此,业界缺乏一种成熟的、低功耗的架构,能够轻松而有效地支持多种 ML 开发框架。

Coral NPU 架构通过颠覆传统芯片设计直接解决了这一问题。它优先考虑机器学习矩阵引擎而非标量计算,从硅片层面优化 AI 架构,打造了一个专为更高效的设备端推理而设计的平台。

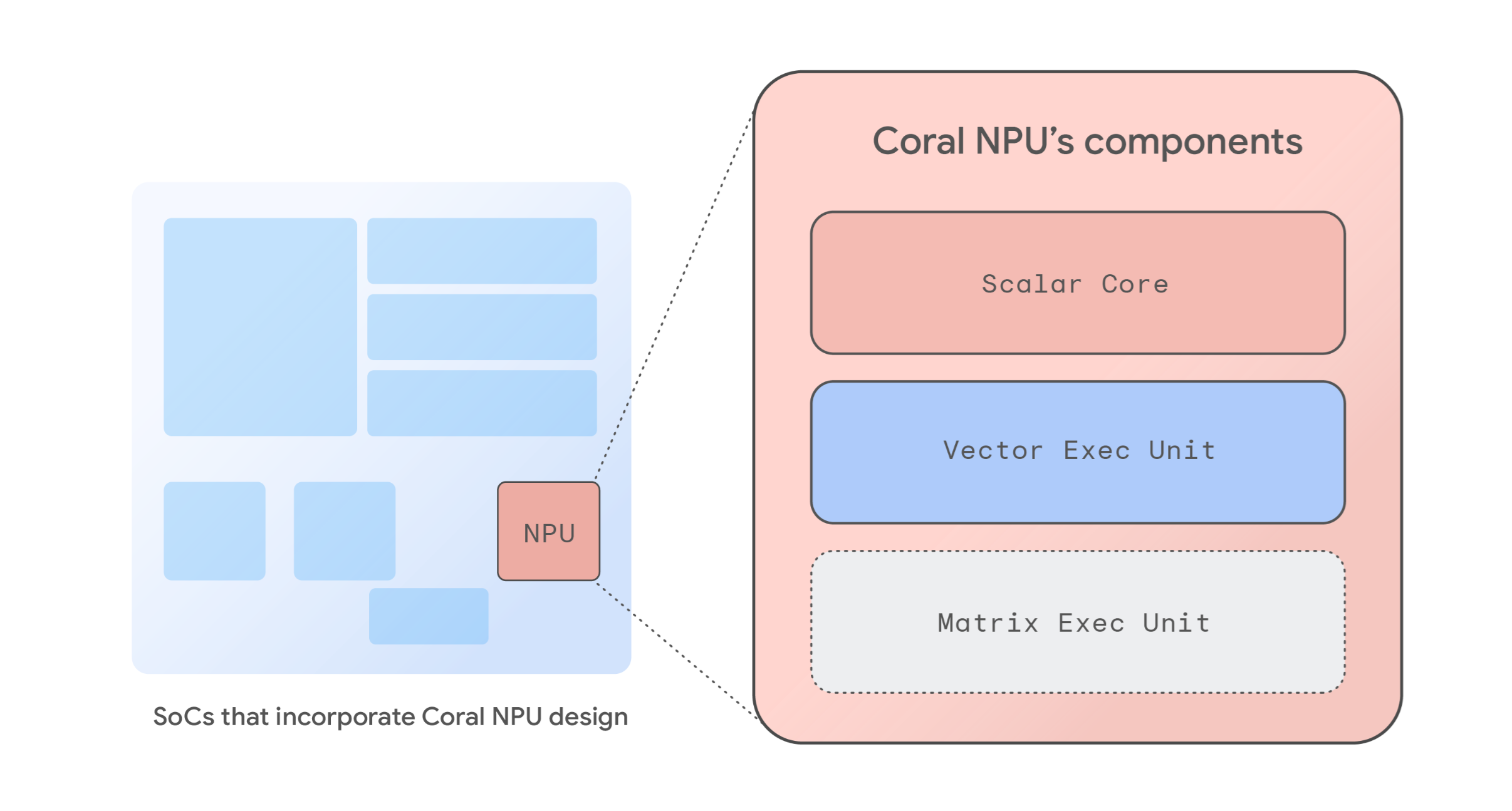

作为一个完整的参考神经处理单元(NPU)架构,Coral NPU 提供了构建下一代节能、机器学习优化系统芯片(SoC)的基础模块。该架构基于一套符合 RISC-V 指令集架构(ISA)的架构 IP 模块设计,旨在实现最低功耗,使其非常适合全天候环境感知。基础设计在仅消耗数毫瓦功率的情况下提供约 512 亿次操作每秒(GOPS)的性能,从而为边缘设备、可穿戴耳机、增强现实眼镜和智能手表提供强大的设备端 AI 能力。

基于 RISC-V 的开放且可扩展架构为 SoC 设计人员提供了灵活性,可以修改基础设计,或者将其用作预配置的 NPU。Coral NPU 架构包括以下组件:

标量核心:一个轻量级、可用 C 语言编程的 RISC-V 前端,管理数据流向后端核心,采用简单的“运行至完成”模式,实现超低功耗和传统 CPU 功能。

向量执行单元:一个强大的单指令流多数据(SIMD)协处理器,符合 RISC-V 向量指令集(RVV)v1.0,可对大数据集同时进行操作。

矩阵执行单元:一个高效的量化外积乘累加(MAC)引擎,专门用于加速基础神经网络操作。请注意,矩阵核心仍在开发中,将于今年晚些时候在 GitHub 上发布。

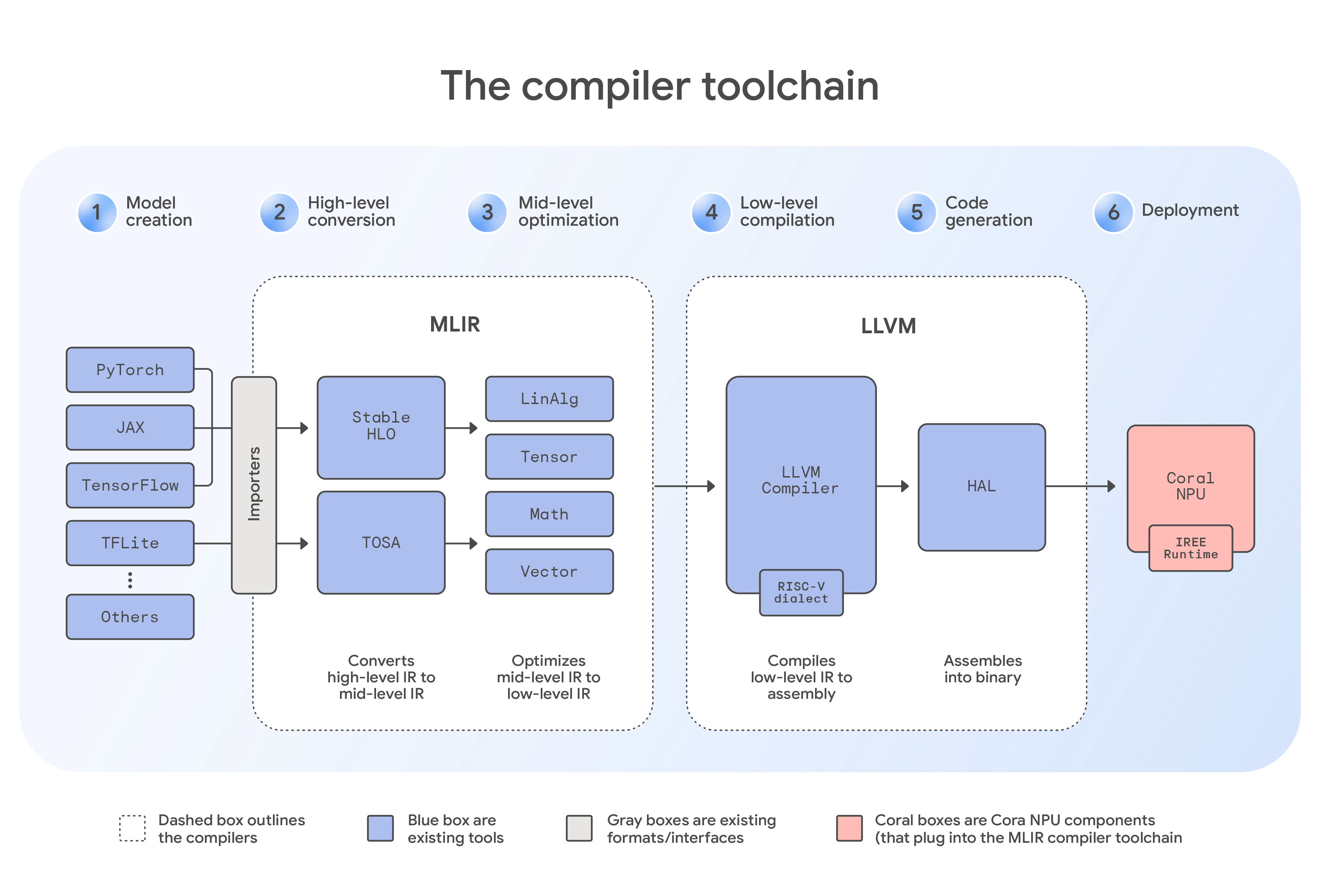

Coral NPU 架构是一种简单的、可用 C 编程的目标,能够与 IREE 和 TFLM 等现代编译器无缝集成。这使得对 TensorFlow、JAX 和 PyTorch 等机器学习框架的支持变得轻而易举。

Coral NPU 包含一个完整的软件工具链,包括针对 TensorFlow 的 TFLM 编译器等专用解决方案,以及通用的 MLIR 编译器、C 编译器、自定义内核和模拟器。这为开发人员提供了灵活的开发途径。例如,来自 JAX 等框架的模型首先通过 StableHLO 方言导入到 MLIR 格式中。然后,这个中间文件被输入到 IREE 编译器中,编译器应用硬件特定的插件以识别 Coral NPU 的架构。从那里,编译器执行渐进下降优化——这是一个关键的优化步骤,在该步骤中,代码通过一系列方言系统地被转换,逐步接近机器的本地语言。优化完成后,工具链生成最终的紧凑二进制文件,准备在边缘设备上高效执行。这一套行业标准的开发者工具有助于简化机器学习模型的编程,并可以在各种硬件目标之间提供一致的体验。

Coral NPU 的协同设计过程聚焦于两个关键领域。首先,该架构能够高效加速当前移动端视觉和音频应用中使用的主流基于编码器的架构。其次,我们正与 Gemma 团队紧密合作,优化 Coral NPU 以适应小型 Transformer 模型,从而帮助确保加速器架构支持下一代边缘生成式 AI。

这种双重关注意味着 Coral NPU 有望成为首款开放的、基于标准的、低功耗 NPU,旨在将大型语言模型(LLM)带入可穿戴设备。对于开发者来说,这提供了一条经过验证的单一路径,以最小的功耗实现最大性能,部署当前和未来的模型。

Coral NPU 旨在支持超低功耗、始终在线的边缘人工智能应用,尤其专注于环境感知系统。其主要目标是在可穿戴设备、手机和物联网(IoT)设备上实现全天候的人工智能体验,同时尽量减少电池消耗。

潜在的使用案例包括:

情境感知:检测用户活动(例如,步行、跑步)、接近度或环境(例如,室内/室外、外出中),以启用“请勿打扰”模式或其他情境感知功能。

音频处理:语音和说话检测、关键词识别、实时翻译、转录以及基于音频的辅助功能。图像处理:人员和物体检测、面部识别、手势识别以及低功耗视觉搜索。

用户交互:通过手势、音频提示或其他传感器驱动的输入实现控制。

Coral NPU 的核心原则是通过硬件强化的安全性来建立用户信任。我们的架构设计旨在支持诸如 CHERI 等新兴技术,CHERI 提供细粒度的内存级安全性和可扩展的软件隔离功能。通过这种方法,我们希望能够将敏感的 AI 模型和个人数据隔离在硬件强化的沙箱中,从而减轻基于内存的攻击风险。

开放硬件项目依赖于强有力的合作伙伴关系才能取得成功。为此,我们正在与 Synaptics 合作,这也是我们的首个战略硅合作伙伴,同时他们在嵌入式计算、无线连接和物联网多模态感知领域处于领先地位。今天,在他们的技术日活动上,Synaptics 宣布了其全新的 Astra™ SL2610 系列 AI 原生物联网处理器。该产品系列配备了他们的 Torq™ NPU 子系统,这是业内首个基于 Coral NPU 架构的量产实现。该 NPU 的设计支持 Transformer,并支持动态操作符,使开发者能够为消费物联网和工业物联网构建面向未来的边缘人工智能系统。

这一合作关系支持我们对统一开发者体验的承诺。Synaptics Torq™ Edge AI 平台基于 IREE 和 MLIR 的开源编译器和运行时构建。这一合作是朝着为智能、上下文感知设备建立共享开放标准迈出的重要一步。

通过 Coral NPU,我们正在为个人 AI 的未来构建基础层。我们的目标是通过提供一个通用、开源且安全的平台,促进一个充满活力的生态系统,让行业在此基础上构建。这使开发者和芯片供应商能够超越当今分散的格局,共同制定边缘计算的统一标准,从而加快创新步伐。了解更多关于 Coral NPU 的信息,并立即开始构建。